人工智能社会学|傲慢与偏见:奥巴马如何“变白”?

- 2020-07-31 18:15

- 澎湃新闻

许多年后,当我们追溯人工智能社会学的编年史时,2020年由丹尼尔深学(Daniel Deep Learning)、Facebook首席人工智能科学家Yann LeCun和谷歌人工智能科学家Timnit Gebru在Twitter上进行的“算法偏见大辩论”可能仍值得记录。尽管这场有争议的辩论持续了两周,并以杨乐坤宣布将永远退出推特而告终,但计算机科学家和社会学家之间在算法上的分歧远未解决。

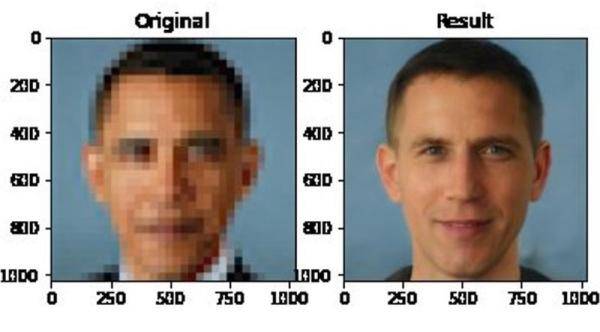

这场争论的起点是一个名为脉冲的算法,它是由杜克大学的科学家在CVPR 2020,计算机视觉的顶级会议上发表的。PULSE的本质在于它能够通过使用生成对抗网络(GAN)的思想来立即澄清模糊的照片。但很快,网民们发现PULSE在黑人社区的表现并不令人满意。例如,当前总统奥巴马的模糊图像被脉冲处理时,产生的清晰图像实际上是一张白脸。

图片来源:推特用户鸡3gg

随着BLM运动(黑色生命物质)在美国的全面展开,脉冲算法引起了很大的争议。面对铺天盖地的质疑,杨乐坤发了一条微博解释道:“机器学习系统的偏差是由数据造成的。脉冲系统由FlickFaceHQ训练,其中大部分是白色图片。如果系统使用塞内加尔的数据集训练,那么每个人看起来都像非洲人。”

从技术角度来看,杨乐坤指出,算法偏差最重要的来源之一是训练数据集的偏差。但是,了解数据偏差就足够了吗?谷歌人工智能科学家,也是一名非裔美国女性,在推特上与杨乐坤展开了激烈的辩论。当时,计算机科学家和社会学家一直站在哪一边。蒂尼特直言不讳地说:你不能把机器学习系统造成的损害归咎于数据偏差。换句话说,是否只要修正了数据偏见,算法偏见(及其造成的伤害)就自动消失了呢?

社会学家的回答是否定的。对他们来说,一个关键的区别是中性的统计偏见和道德导入的偏见,这给社会群体带来了真正的后果。1996年,巴特亚弗里德曼和海伦尼森鲍姆写了《计算机系统的偏差》(计算机系统中的偏差),这在今天仍然是经典之作。当然,他们当时所说的偏见与今天在人工智能系统中观察到的偏见大相径庭。然而,他们提出了一个经典的定义,将偏见与道德意义上的偏见区分开来。如果前者一般可以指计算系统中的各种自然“偏差”,后者则指对某个社会群体的特定不公平伤害。今天,我们讨论算法偏差,尤其是后者。

也许一个经典的例子是亚马逊和网飞的算法推荐系统,你可以在淘宝和颤音上找到类似的系统。这些算法会根据你以前的浏览和评估记录(或者那些与你的用户肖像相似的用户的记录),向你推荐“可能”有趣的产品和电影。

统计学家发现,类似的算法至少受四个统计偏差的约束。第一种偏差是新产品或电影通常很难被推荐算法选择。由于算法是基于用户评分的,新产品没有评分,所以很难进入算法的视野。

第二种偏差是流行商品或电影经常被反复挑选。即使你只读过中世纪的医学史,你也可能会被推《哈利波特》 ——,因为在浩瀚的用户海洋中,总有喜欢《哈利波特》的人,而他们恰好喜欢中世纪的医学史。

第三种偏差更加复杂。统计学家发现这个算法“太精细了”。如果你碰巧看了三部《倚天屠龙记》的电影,出于对准确性的不懈追求,该算法将基本上继续向你推荐武侠小说,即使你本周想探索科幻电影。

第四种偏差是同质化。因为算法会自动推荐其他用户喜欢的产品,所以评价较低的利基产品会慢慢下沉,整个信息生态系统会变得越来越相似。例如,引用率高的论文会被重复引用,这将导致更多的引用,形成一个信息闭环。

社会学家很快发现,当我们讨论统计偏差时,我们经常忽略社会群体中看似正常的偏差所造成的危害。许多看似完全自然无害的统计偏差可能会导致严重的社会后果。在上面的例子中,过于复杂的算法可能会导致个人信息系统的同质化,从而导致社会环境的碎片化:保守派和自由派可能会看到完全不同的世界。

同样,如果算法是为“大多数用户”设计的,那些占据正态分布尾部的少数用户自然会遭受不同程度的“算法歧视”。从另一个角度来看,将正态分布末端的用户群体排除在算法的视野之外也对“大多数”用户有害:人类信息系统像自然生态系统一样,将遭受多样性的损失。

更致命的是,在类似的推荐系统或广义的现代信息过滤系统中,数据和算法是不可分离的。该算法根据成千上万用户的选择和分数不断实时更新其预测系统。算法偏差在哪里?

此外,我们还可以问,在某种程度上,将人工智能系统造成的社会偏见和伤害归咎于“数据”而不是“系统”本身是否在逃避责任?如果只有数据是有偏见的,那么应该只有那些收集和标注数据的人对所有的社会后果负责吗?通过将责任的愿景限制在训练数据集上,我们实际上从一开始就放弃了查询整个人工智能系统的基础:为什么要建造这个系统?谁建造了这个系统?谁会受益于这个系统?谁又会受到最大程度的影响?

当代深度学习领域的领军人物杨乐坤,在就算法偏见争论了两周之后,彻底退出了推特。在人类社会和算法的交汇处,人工智能算法正与时间赛跑,从亿万用户的行为中提取数据进行预测,因此从科学技术的角度理解和解决问题可能会受到越来越多的挑战。

普林斯顿大学的社会学家Ruha Benjamin在一个关于深度学习的著名会议“ICLR 2020”上说。

没有历史或社会学深度的计算深度是肤浅的学习.

没有历史和社会深度的“深度学习”只是“浅薄学习”。

与所有计算机科学家和社会学家分享。

[参考文献]

[1]巴特亚弗里德曼和海伦尼森伯姆。计算机系统中的偏见。美国计算机学会信息系统交易(TOIS) 14,第3期(1996): 330-347。

[2]鲁哈本杰明。ICLR 2020:“愿景:重新构想技术社会的默认设置。”

[3]萨希特梅农、亚历山德鲁达米安、时嘉胡、尼克希尔拉维、辛西娅鲁丁。“通过生成模型的潜在空间探索进行自我监督的照片上采样”,IEEE/CVF计算机视觉和模式识别会议论文集(CVPR),2020年,第2437-2445页。

[4]凯瑟琳斯丁森。算法会有偏差吗?“。2020.

-

作者沈虹,毕业于美国伊利诺伊大学香槟分校传播学系,现任职于美国卡内基梅隆大学。她用社会学的方法研究新兴科技。

- 公安部交管局公布今年上半年事故多发路段2020-07-27 11:24

- 全球深空探索走进新时代2020-07-27 09:06

- 四部门:遏制货车非法改装 严厉打击百吨王2020-07-27 07:18

- “四个一百”优秀政法新媒体榜单正式发布2020-07-27 07:16

- 多地出台稳外贸稳外资“加强版”举措2020-07-24 09:11

-

2

上海海警查获5起涉嫌走私案件 涉案金额2000万元

上海海警查获5起涉嫌走私案件 涉案金额2000万元

2020-07-22 07:16

-

3

高科技重新定义新时代抢险抗洪

高科技重新定义新时代抢险抗洪

2020-07-21 07:24

-

4

2020第五届大致坡琼剧文化节在海口启幕

2020第五届大致坡琼剧文化节在海口启幕

2020-07-13 08:56

-

5

黔东南州非遗大集市在丹寨万达小镇开市

黔东南州非遗大集市在丹寨万达小镇开市

2020-07-08 07:29